Natuurlijk kan uw AI-assistent een afspraak voor u maken, maar hoe zit het met een zinvol gesprek? Shutterstock / Bas Nastassia

Natuurlijk kan uw AI-assistent een afspraak voor u maken, maar hoe zit het met een zinvol gesprek? Shutterstock / Bas Nastassia

Google recent onthuld zijn nieuwste pratende AI, genaamd Duplex. Duplex klinkt als een echt persoon, compleet met pauzes, "umms" en "ahhs".

De techgigant zegt dat hij met mensen aan de telefoon kan praten om afspraken te maken en openingstijden te controleren.

In opgenomen gesprekken die werden gespeeld bij de onthulling van Google, sprak het naadloos met de mensen aan de ontvangende kant, die totaal niet wisten dat ze niet met een andere persoon spraken.

Deze oproepen verlieten de technologiegericht publiek op de Google-show hijgend en gejuich. In één voorbeeld begreep de AI zelfs wanneer de persoon met wie hij sprak in de war raakte, en kon hij het gesprek blijven volgen en gepast reageren toen hem werd verteld dat hij geen boeking hoefde te maken.

De opkomst van de AI-assistenten

Als je een van de momenteel beschikbare stemassistenten hebt gebruikt, zoals Google Home, Apple's Siri of Amazon Echo, zal deze flexibiliteit u misschien verbazen. Deze assistenten zijn notoir moeilijk te gebruiken voor iets anders dan de standaardverzoeken, zoals een contactpersoon bellen, een nummer afspelen, een eenvoudige zoekopdracht op internet uitvoeren of een herinnering instellen.

Wanneer we met deze assistenten van de huidige generatie spreken, zijn we ons er altijd van bewust dat we met een AI praten en passen we vaak wat we zeggen dienovereenkomstig aan, op een manier waarvan we hopen dat we onze kansen om het te laten werken, maximaliseren.

Maar de mensen die met Duplex spraken, hadden geen idee. Ze aarzelden, keerden terug, sloegen woorden over en veranderden zelfs de feiten halverwege een zin. Duplex miste geen enkele beat. Het leek echt te begrijpen wat er aan de hand was.

Lees verder: Slimme luidsprekers kunnen het omslagpunt zijn voor domotica

Dus is de toekomst eerder aangekomen dan iedereen had verwacht? Staat de wereld op het punt vol te zitten met online (en telefonische) AI-assistenten die gelukkig chatten en alles voor ons doen? Of erger nog, worden we plotseling omringd door intelligente AI's met hun eigen gedachten en ideeën die ons al dan niet mensen kunnen omvatten?

Het antwoord is een duidelijk "nee". Om te begrijpen waarom, helpt het om snel onder de motorkap te kijken wat een AI als deze drijft.

Duplex: hoe het werkt

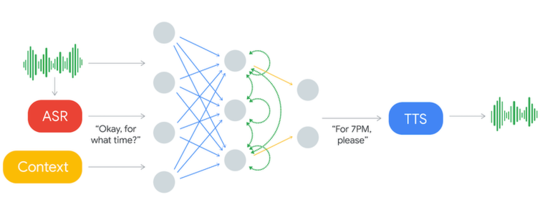

Dit is wat de Duplex AI-systeem er uit ziet.

Inkomend geluid wordt verwerkt via een ASR-systeem. Dit produceert tekst die wordt geanalyseerd met contextgegevens en andere invoer om een antwoordtekst te produceren die hardop wordt voorgelezen via het tekst-naar-spraak (TTS) -systeem. Kopen Google Reviews

Inkomend geluid wordt verwerkt via een ASR-systeem. Dit produceert tekst die wordt geanalyseerd met contextgegevens en andere invoer om een antwoordtekst te produceren die hardop wordt voorgelezen via het tekst-naar-spraak (TTS) -systeem. Kopen Google Reviews

Het systeem neemt "input" (links weergegeven), de stem van de persoon waarmee het aan de telefoon praat. De stem gaat door automatische spraakherkenning (ASR) en wordt omgezet in tekst (geschreven woorden). De ASR is zelf een geavanceerd AI-systeem, maar van een type dat al veel wordt gebruikt bij bestaande stemassistenten.

De tekst wordt vervolgens gescand om het type zin te bepalen (zoals een begroeting, een verklaring, een vraag of een instructie) en om belangrijke informatie te extraheren. De sleutelinformatie wordt dan onderdeel van de Context, wat extra input is die het systeem up-to-date houdt met wat er tot nu toe in het gesprek is gezegd.

De tekst van de ASR en de context wordt vervolgens naar het hart van Duplex gestuurd, dat een Artificial Neural Network (ANN) wordt genoemd.

In het bovenstaande diagram wordt de ANN weergegeven door de cirkels en de lijnen die ze verbinden. ANNs zijn losjes gemodelleerd naar onze hersenen, die miljarden neuronen met elkaar verbonden hebben tot enorme netwerken.

Nog niet echt een brein

ANNs zijn echter veel eenvoudiger dan onze hersenen. Het enige dat deze probeert te doen, is de invoerwoorden matchen met een passend antwoord. De ANN leert door transcripties te zien van duizenden gesprekken van mensen die boekingen maken voor restaurants.

Met voldoende voorbeelden leert het wat voor soort inputzinnen je kunt verwachten van de persoon met wie je praat, en wat voor soort reacties op elk van hen moeten worden gegeven.

De tekstreactie die de ANN genereert, wordt vervolgens naar een tekst-naar-spraak (TTS) -synthesizer gestuurd, die deze omzet in gesproken woorden die vervolgens worden afgespeeld voor de persoon aan de telefoon.

Nogmaals, deze TTS-synthesizer is een geavanceerde AI - in dit geval is hij geavanceerder dan die op je telefoon, omdat hij bijna niet te onderscheiden is van een normale stem.

Dat is alles. Ondanks dat het state-of-the-art is, is het hart van het systeem eigenlijk slechts een tekst matching proces. Maar je zou je kunnen afvragen: als het zo simpel is, waarom zouden we het dan niet eerder kunnen doen?

Een aangeleerde reactie

Feit is dat menselijke taal, en de meeste andere dingen in de echte wereld, te variabel en wanordelijk zijn om goed door normale computers te worden afgehandeld, maar dit soort problemen is perfect voor AI.

Merk op dat de output die door de AI wordt geproduceerd volledig afhangt van de gesprekken die werden getoond tijdens het leren.

Dit betekent dat verschillende AI's getraind moeten worden om verschillende soorten boekingen te maken - zo kan de ene AI bijvoorbeeld restaurants boeken en de andere haarafspraken.

Dit is nodig omdat de soorten vragen en antwoorden zo verschillend kunnen zijn voor verschillende soorten boekingen. Dit is ook hoe Duplex zo veel beter kan zijn dan de algemene stemassistenten, die veel soorten verzoeken moeten afhandelen.

Dus nu moet het duidelijk zijn dat we binnenkort geen informele gesprekken zullen voeren met onze AI-assistenten. In feite zijn al onze huidige AI's eigenlijk niets meer dan patroonmatchers (in dit geval overeenkomende tekstpatronen). Ze begrijpen niet wat ze horen, waar ze naar kijken of wat ze zeggen.

Patronen matchen is één ding dat onze hersenen doen, maar ze doen nog veel meer. De sleutel tot het creëren van krachtigere AI kan zijn om meer van de geheimen van de hersenen te ontsluiten. Willen we? Nou dat is een andere vraag.![]()

Over de auteur

Peter Stratton, postdoctoraal onderzoeker, De universiteit van Queensland

Dit artikel is opnieuw gepubliceerd vanaf The Conversation onder een Creative Commons-licentie. Lees de originele artikel.