Twitter-screenshots / Unsplash, auteur voorzien

Twitter heeft afgelopen weekend een video "getagd" als gemanipuleerd waarin de Amerikaanse democratische presidentskandidaat Joe Biden zou vergeten in welke staat hij zich bevindt terwijl hij een menigte toesprak.

Biden's begroeting met "hallo Minnesota" contrasteerde met prominente bewegwijzering met de tekst "Tampa, Florida" en "Tekst FL naar 30330".

De feitencontrole van Associated Press bevestigd de borden werden digitaal toegevoegd en de originele beelden waren inderdaad van een bijeenkomst in Minnesota. Maar tegen de tijd dat de misleidende video werd verwijderd, was deze al meer dan een miljoen keer bekeken, The Guardian rapporten.

Een VALSE video waarin wordt beweerd dat Biden was vergeten in welke staat hij verkeerde, werd de afgelopen 1 uur meer dan 24 miljoen keer bekeken op Twitter

- Donie O'Sullivan (@donie) 1 november 2020

In de video zegt Biden "Hallo, Minnesota."

Het evenement vond inderdaad plaats in MN - op het podium stond MN

Maar valse video bewerkte borden om Florida te lezen pic.twitter.com/LdHQVaky8v

Als u sociale media gebruikt, is de kans groot dat u enkele van de meer dan ziet (en doorstuurt) 3.2 miljard afbeeldingen en 720,000 uur kunt opladen van video dagelijks gedeeld. Wanneer we worden geconfronteerd met zo'n overvloed aan inhoud, hoe kunnen we dan weten wat echt is en wat niet?

Hoewel een deel van de oplossing een toenemend gebruik van inhoudverificatietools is, is het even belangrijk dat we allemaal onze digitale mediageletterdheid stimuleren. Uiteindelijk ben jij een van de beste verdedigingslinies - en de enige die je kunt controleren.

Zien zou niet altijd moeten geloven

Verkeerde informatie (wanneer u per ongeluk valse inhoud deelt) en desinformatie (wanneer u deze opzettelijk deelt) op welk medium dan ook het vertrouwen in burgerlijke instellingen aantasten zoals nieuwsorganisaties, coalities en sociale bewegingen. Nepfoto's en -video's zijn echter vaak het krachtigst.

Voor degenen met een gevestigd politiek belang kan het creëren, delen en / of bewerken van valse afbeeldingen kijkers afleiden, verwarren en manipuleren om onenigheid en onzekerheid te zaaien (vooral in reeds gepolariseerde omgevingen). Posters en platforms kunnen ook geld verdienen met het delen van neppe, sensationele inhoud.

Alleen 11-25% van de journalisten maakt volgens het International Center for Journalists wereldwijd gebruik van tools voor verificatie van inhoud via sociale media.

Kunt u een gemanipuleerd beeld zien?

Beschouw deze foto van Martin Luther King Jr.

Dr. Martin Luther King Jr. Geeft de middelvinger #DopeHistorischePics pic.twitter.com/5W38DRaLHr

- Dope Historic Pics (@dopehistoricpic) 20 december 2013

Deze veranderd beeld kloont een deel van de achtergrond over de vinger van King Jr, zodat het lijkt alsof hij de camera uitschakelt. Het is gedeeld als echt op Twitter, Reddit en blanke supremacistische websites.

In het origineel Foto uit 1964, King flitste het "V for Victory" -teken nadat hij hoorde dat de Amerikaanse Senaat de burgerrechtenwet had aangenomen.

"Wie van vrede houdt, moet leren zich net zo effectief te organiseren als wie van oorlog houdt."

- Willie's Reserve (@WilliesReserve) 21 januari 2019

Dr. Martin Luther King Jr.

??

Deze foto is gemaakt op 19 juni 1964 en toont Dr. King die een vredesteken geeft nadat hij had gehoord dat de wet op de burgerrechten de senaat was gepasseerd. @snoep pic.twitter.com/LXHmwMYZS5

Naast het toevoegen of verwijderen van elementen, is er een hele categorie fotomanipulatie waarbij afbeeldingen worden samengevoegd.

Eerder dit jaar, een foto van een gewapende man werd gefotoshopt door Fox News, die de man over andere scènes heen legde zonder de bewerkingen openbaar te maken, de Seattle Times gerapporteerd.

Bedoel je deze man die gefotoshopt is in drie afzonderlijke foto's die zijn uitgebracht door Fox News? pic.twitter.com/fAXpIKu77a

— Zander Yates ???????? ???? ???????? (@ZanderYates) 13 June 2020

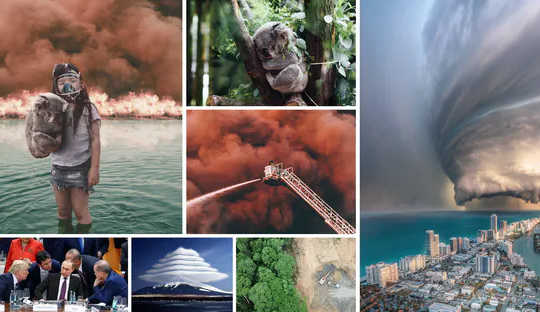

Evenzo is de beeld hieronder werd duizenden keren gedeeld op sociale media in januari, tijdens de Black Summer-bosbranden in Australië. De feitencontrole van de AFP bevestigd het is niet authentiek en is eigenlijk een combinatie van verscheidene apart foto's.

Het beeld is krachtiger dan het geschreeuw van Greta. Een stil meisje houdt een koala vast. Ze kijkt je recht aan vanuit het water van de oceaan waar ze een toevluchtsoord hebben gevonden. Ze draagt een ademmasker. Een muur van vuur is achter hen. Ik weet de naam van de fotograaf niet #Australië pic.twitter.com/CrTX3lltdh

- EVC Music (@EVCMusicUK) 6 januari 2020

Volledig en gedeeltelijk synthetische inhoud

Online vindt u ook geavanceerde "deepfake”Video's met (meestal beroemde) mensen die dingen zeggen of doen die ze nooit hebben gedaan. Met apps kunnen minder geavanceerde versies worden gemaakt zoals Zao en opnieuw bekijken.

{besloten Y=yaq4sWFvnAY}

Een team van het Massachusetts Institute of Technology heeft deze nepvideo gemaakt waarin de Amerikaanse president Richard Nixon regels voorleest uit een toespraak voor het geval de maanlanding in 1969 mislukte. (Youtube)

Of, als u uw foto niet voor een profielfoto wilt gebruiken, kunt u standaard een van meerdere gebruiken websites bieden honderdduizenden door AI gegenereerde, fotorealistische afbeeldingen van mensen.

Deze mensen bestaan niet, het zijn gewoon afbeeldingen die zijn gegenereerd door kunstmatige intelligentie. Gegenereerde foto's, CC BY

Pixelwaarden bewerken en het (niet zo) simpele bijsnijden

Bijsnijden kan ook de context van een foto aanzienlijk veranderen.

We zagen dit in 2017, toen een medewerker van de Amerikaanse overheid officiële foto's van de inauguratie van Donald Trump bewerkte om de menigte groter te laten lijken, volgens The Guardian. De stafmedewerker sneed de lege ruimte "waar de menigte eindigde" uit voor een reeks foto's voor Trump.

Uitzicht op de menigte bij de inhuldigingen van de voormalige Amerikaanse president Barack Obama in 2009 (links) en president Donald Trump in 2017 (rechts). AP

Uitzicht op de menigte bij de inhuldigingen van de voormalige Amerikaanse president Barack Obama in 2009 (links) en president Donald Trump in 2017 (rechts). AP

Maar hoe zit het met bewerkingen die alleen pixelwaarden veranderen, zoals kleur, verzadiging of contrast?

Een historisch voorbeeld illustreert de gevolgen hiervan. In 1994 publiceerde het tijdschrift Time deksel van OJ Simpson aanzienlijk "verduisterd" Simpson in zijn politie mugshot. Dit gaf brandstof aan een zaak die al geplaagd werd door raciale spanningen, waaraan het tijdschrift gereageerd:

Er was geen raciale implicatie bedoeld, door de tijd of door de kunstenaar.

U denkt misschien aan deze controverse uit 1994. Het tijdschrift Time kwam in de problemen omdat het de mugshot van OJ Simpson verduisterde en moest uiteindelijk de kwestie intrekken. Het is waarschijnlijk het bekendste voorbeeld van zoiets. En ja, ik ben zelf aan het daten, ik weet het. pic.twitter.com/7U7Yw7XZGU

- Pilar Pedraza TV (@PilarPedrazaTV) 2 november 2020

Tools voor het ontmaskeren van digitale vervalsing

Voor degenen onder ons die niet willen worden bedrogen door visuele verkeerde informatie / desinformatie, zijn er tools beschikbaar - hoewel elk zijn eigen beperkingen heeft (iets dat we bespreken in onze recente papier).

onzichtbaar digitale watermerken is als oplossing voorgesteld. Het is echter niet wijdverbreid en vereist buy-in van zowel uitgevers als distributeurs van inhoud.

Omgekeerd zoeken naar afbeeldingen (zoals Google) is vaak gratis en kan nuttig zijn om eerdere, mogelijk meer authentieke kopieën van afbeeldingen online te identificeren. Dat gezegd hebbende, het is niet waterdicht omdat het:

- vertrouwt op onbewerkte kopieën van de media die al online zijn

- zoekt niet in het GEHELE web

- laat niet altijd filteren op publicatietijd toe. Sommige zoekservices voor omgekeerd beeld, zoals TinEye ondersteunen deze functie, maar die van Google niet.

- retourneert alleen exacte overeenkomsten of bijna-overeenkomsten, dus het is niet grondig. Als u bijvoorbeeld een afbeelding bewerkt en vervolgens de oriëntatie omdraait, kan Google denken dat het een heel andere is.

De meeste betrouwbare tools zijn geavanceerd

Ondertussen zijn handmatige forensische detectiemethoden voor visuele mis / desinformatie meestal gericht op bewerkingen die zichtbaar zijn voor het blote oog, of vertrouwen op het onderzoeken van functies die niet in elk beeld zijn opgenomen (zoals schaduwen). Ze zijn ook tijdrovend, duur en hebben gespecialiseerde expertise nodig.

Toch kunt u toegang krijgen tot werk op dit gebied door sites zoals Snopes.com te bezoeken, die een groeiende opslagplaats hebben van "fauxtografie'.

Computervisie en machine learning bieden ook relatief geavanceerde detectiemogelijkheden voor afbeeldingen en videos. Maar ook zij hebben technische expertise nodig om te kunnen werken en begrijpen.

Bovendien vereist het verbeteren ervan het gebruik van grote hoeveelheden "trainingsgegevens", maar de beeldopslagplaatsen die hiervoor worden gebruikt, bevatten meestal niet de echte beelden die in het nieuws te zien zijn.

Als u een beeldverificatietool gebruikt zoals het REVEAL-project afbeelding verificatie assistentheeft u wellicht een expert nodig om de resultaten te helpen interpreteren.

Het goede nieuws is echter dat voordat u zich tot een van de bovenstaande tools wendt, er enkele eenvoudige vragen zijn die u uzelf kunt stellen om er mogelijk achter te komen of een foto of video op sociale media nep is. Denken:

- was het oorspronkelijk gemaakt voor sociale media?

- hoe wijd en hoe lang is het verspreid?

- welke reacties heeft het ontvangen?

- wie waren de beoogde doelgroepen?

Vaak zijn de logische conclusies die uit de antwoorden worden getrokken voldoende om niet-authentieke beelden te verwijderen. Je hebt toegang tot de volledige lijst met vragen, opgesteld door experts van Manchester Metropolitan University, hier.![]()

Over de auteurs

TJ Thomson, hoofddocent visuele communicatie en media, Queensland University of Technology; Daniel Angus, universitair hoofddocent digitale communicatie, Queensland University of Technology, en Paula Dootson, hoofddocent, Queensland University of Technology

Dit artikel is opnieuw gepubliceerd vanaf The Conversation onder een Creative Commons-licentie. Lees de originele artikel.