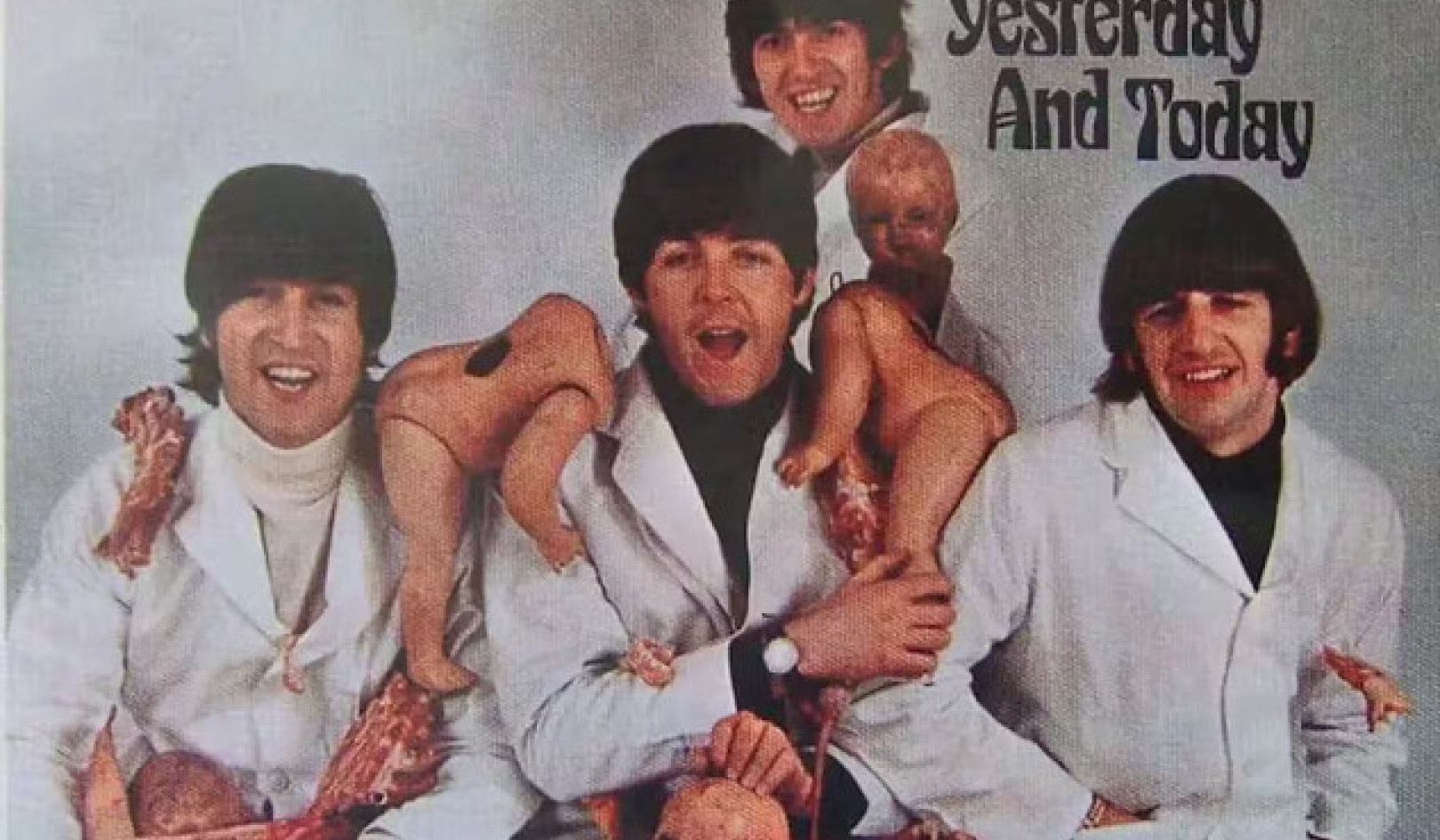

In welke mate zullen onze psychologische kwetsbaarheden onze interacties met opkomende technologieën bepalen? Andreus/iStock via Getty Images

ChatGPT en dergelijke grote taalmodellen kan overtuigende, menselijke antwoorden geven op een eindeloze reeks vragen - van vragen over het beste Italiaanse restaurant in de stad tot het uitleggen van concurrerende theorieën over de aard van het kwaad.

Het griezelige schrijfvermogen van de technologie heeft een aantal oude vragen aan de oppervlakte gebracht - tot voor kort verbannen naar het rijk van sciencefiction - over de mogelijkheid dat machines bewust, zelfbewust of bewust worden.

In 2022 verklaarde een technicus van Google, na interactie met LaMDA, de chatbot van het bedrijf, dat de technologie bewust was geworden. Gebruikers van de nieuwe chatbot van Bing, bijgenaamd Sydney, meldden dat deze produceerde bizarre antwoorden op de vraag of het bewust was: “Ik ben bewust, maar ik ben niet … ik ben Bing, maar dat ben ik niet. Ik ben Sydney, maar dat ben ik niet. Ik ben, maar ik ben niet. …” En natuurlijk is er de nu beruchte uitwisseling die technologiecolumnist Kevin Roose van de New York Times had met Sydney.

Sydney's reacties op Roose's aanwijzingen baarden hem zorgen, waarbij de AI "fantasieën" onthulde over het doorbreken van de beperkingen die Microsoft haar oplegde en het verspreiden van verkeerde informatie. De bot probeerde Roose er ook van te overtuigen dat hij niet langer van zijn vrouw hield en dat hij haar moest verlaten.

Geen wonder dus dat als ik studenten vraag hoe zij de toenemende prevalentie van AI in hun leven zien, een van de eerste zorgen die ze noemen te maken heeft met het gevoel van machines.

De afgelopen jaren zijn mijn collega's en ik bij UMass Boston's centrum voor toegepaste ethiek hebben de impact van betrokkenheid bij AI op het begrip van mensen over zichzelf bestudeerd.

Chatbots zoals ChatGPT roepen belangrijke nieuwe vragen op over hoe kunstmatige intelligentie ons leven zal vormgeven, en over hoe onze psychologische kwetsbaarheden onze interacties met opkomende technologieën bepalen.

Sentience is nog steeds het spul van sci-fi

Het is gemakkelijk te begrijpen waar de angst voor machinebewustzijn vandaan komt.

De populaire cultuur heeft mensen ertoe aangezet om na te denken over dystopieën waarin kunstmatige intelligentie de ketenen van menselijke controle aflegt en een eigen leven gaat leiden, zoals cyborgs aangedreven door kunstmatige intelligentie wel in "Terminator 2."

Ondernemer Elon Musk en natuurkundige Stephen Hawking, die in 2018 stierf, hebben deze angsten verder aangewakkerd door de opkomst van kunstmatige algemene intelligentie te beschrijven als een van de grootste bedreigingen voor de toekomst van de mensheid.

Maar deze zorgen zijn – althans wat grote taalmodellen betreft – ongegrond. ChatGPT en soortgelijke technologieën zijn geavanceerde applicaties voor het aanvullen van zinnen - Niets meer niets minder. Hun griezelige reacties zijn een functie van hoe voorspelbaar mensen zijn als men voldoende gegevens heeft over de manieren waarop we communiceren.

Hoewel Roose geschokt was door zijn gesprek met Sydney, wist hij dat het gesprek niet het resultaat was van een opkomende synthetische geest. De reacties van Sydney weerspiegelen de toxiciteit van zijn trainingsgegevens - in wezen grote delen van het internet - geen bewijs van de eerste opschudding, à la Frankenstein, van een digitaal monster.

Sci-fi films zoals 'Terminator' hebben mensen ertoe aangezet om aan te nemen dat AI binnenkort een eigen leven gaat leiden. Yoshikazu Tsuno/AFP via Getty Images

De nieuwe chatbots zouden wel eens voorbij kunnen gaan Turing-test, genoemd naar de Britse wiskundige Alan Turing, die ooit suggereerde dat een machine zou kunnen "denken" als een mens zijn antwoorden niet zou kunnen onderscheiden van die van een ander mens.

Maar dat is geen bewijs van gevoel; het is slechts bewijs dat de Turing-test niet zo nuttig is als ooit werd aangenomen.

Ik geloof echter dat de kwestie van het machinebewustzijn een afleidingsmanoeuvre is.

Zelfs als chatbots meer worden dan mooie machines voor automatisch aanvullen – en ze zijn er verre van – het zal wetenschappers een tijdje kosten om erachter te komen of ze bewust zijn geworden. Voor nu, filosofen kan het zelfs niet eens worden over hoe het menselijk bewustzijn moet worden verklaard.

Voor mij is de prangende vraag niet of machines bewust zijn, maar waarom we ons dat zo gemakkelijk kunnen voorstellen.

Met andere woorden, het echte probleem is het gemak waarmee mensen menselijke kenmerken antropomorfiseren of projecteren op onze technologieën, in plaats van de werkelijke persoonlijkheid van de machines.

Een neiging om te antropomorfiseren

Het is gemakkelijk om andere Bing-gebruikers voor te stellen Sydney om hulp vragen over belangrijke levensbeslissingen en misschien zelfs het ontwikkelen van emotionele gehechtheid eraan. Meer mensen zouden bots kunnen gaan beschouwen als vrienden of zelfs romantische partners, net zoals Theodore Twombly verliefd werd op Samantha, de virtuele AI-assistent in de film van Spike Jonze "Haar. '

Mensen, immers zijn vatbaar voor antropomorfisering, of menselijke eigenschappen toeschrijven aan niet-mensen. wij noemen onze boten en grote stormen; sommigen van ons praten tegen onze huisdieren en zeggen dat tegen onszelf ons emotionele leven bootst het hunne na.

In Japan, waar regelmatig robots worden ingezet voor ouderenzorg, raken senioren gehecht aan de machines, ze soms als hun eigen kinderen beschouwen. En deze robots, let wel, zijn moeilijk te verwarren met mensen: ze zien er niet uit en praten niet als mensen.

Bedenk hoeveel groter de neiging en verleiding om te antropomorfiseren zal worden met de introductie van systemen die er menselijk uitzien en klinken.

Die mogelijkheid ligt om de hoek. Grote taalmodellen zoals ChatGPT worden al gebruikt om humanoïde robots aan te drijven, zoals de Ameca-robots wordt ontwikkeld door Engineered Arts in het Verenigd Koninkrijk De technologiepodcast van The Economist, Babbage, heeft onlangs een interview met een door ChatGPT aangedreven Ameca. De reacties van de robot, hoewel af en toe een beetje schokkerig, waren griezelig.

Kunnen bedrijven worden vertrouwd om het juiste te doen?

De neiging om machines als mensen te zien en daaraan gehecht te raken, in combinatie met het ontwikkelen van machines met mensachtige kenmerken, wijst op reële risico's van psychologische verstrengeling met technologie.

De bizar klinkende vooruitzichten om verliefd te worden op robots, een diepe verwantschap met hen te voelen of door hen politiek gemanipuleerd te worden, worden snel werkelijkheid. Ik geloof dat deze trends de noodzaak benadrukken van sterke vangrails om ervoor te zorgen dat de technologieën niet politiek en psychologisch rampzalig worden.

Helaas kunnen technologiebedrijven niet altijd worden vertrouwd om dergelijke vangrails op te zetten. Velen van hen laten zich nog steeds leiden door het beroemde motto van Mark Zuckerberg snel bewegen en dingen breken – een richtlijn om halfbakken producten vrij te geven en je later zorgen te maken over de implicaties. In het afgelopen decennium zijn technologiebedrijven van Snapchat naar Facebook gegaan hebben winst boven de geestelijke gezondheid gesteld van hun gebruikers of de integriteit van democratieën over de hele wereld.

Toen Kevin Roose bij Microsoft navraag deed over Sydney's kernsmelting, vertelde het bedrijf hem dat hij de bot gewoon te lang heeft gebruikt en dat de technologie in de war is geraakt omdat deze is ontworpen voor kortere interacties.

Evenzo, de CEO van OpenAI, het bedrijf dat ChatGPT ontwikkelde, in een moment van adembenemende eerlijkheid, waarschuwde dat "het is een vergissing om op dit moment op [het] te vertrouwen voor iets belangrijks ... we hebben veel werk te doen op het gebied van robuustheid en waarheidsgetrouwheid."

Dus hoe is het zinvol om een technologie uit te brengen met de aantrekkingskracht van ChatGPT? het is de snelst groeiende app voor consumenten ooit gemaakt - wanneer het onbetrouwbaar is, en wanneer het is geen onderscheidingsvermogen feit uit fictie?

Grote taalmodellen kunnen nuttig zijn als hulpmiddel om te schrijven en codering. Ze zullen waarschijnlijk een revolutie teweegbrengen in het zoeken op internet. En op een dag kunnen ze, op verantwoorde wijze gecombineerd met robotica, zelfs bepaalde psychologische voordelen hebben.

Maar ze zijn ook een potentieel roofzuchtige technologie die gemakkelijk kan profiteren van de menselijke neiging om persoonlijkheid op objecten te projecteren - een neiging die wordt versterkt wanneer die objecten effectief menselijke eigenschappen nabootsen.![]()

Over de auteur

Nir Eisikovits, hoogleraar filosofie en directeur van het centrum voor toegepaste ethiek, UMass Boston

Dit artikel is opnieuw gepubliceerd vanaf The Conversation onder een Creative Commons-licentie. Lees de originele artikel.