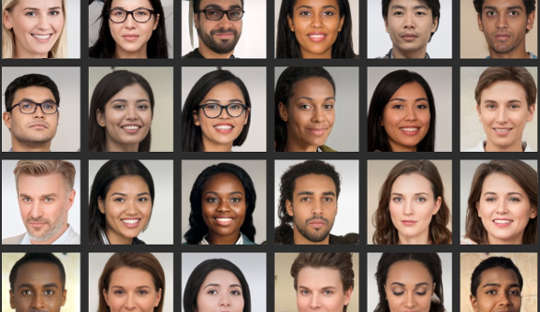

Zelfs als je denkt dat je goed bent in het analyseren van gezichten, onderzoek toont aan veel mensen kunnen geen betrouwbaar onderscheid maken tussen foto's van echte gezichten en afbeeldingen die door de computer zijn gegenereerd. Dit is vooral problematisch nu computersystemen realistisch ogende foto's kunnen maken van mensen die niet bestaan.

Onlangs haalde een nep-LinkedIn-profiel met een door de computer gegenereerde profielfoto het nieuws succesvol verbonden met Amerikaanse functionarissen en andere invloedrijke personen op het netwerkplatform bijvoorbeeld. Contraspionage-experts zeggen zelfs dat spionnen routinematig fantoomprofielen met dergelijke foto's maken huis in op buitenlandse doelen via sociale media.

Deze diepe vervalsingen worden wijdverspreid in de alledaagse cultuur, wat betekent dat mensen zich meer bewust moeten zijn van hoe ze worden gebruikt in marketing, advertenties en sociale media. De beelden worden ook gebruikt voor kwaadaardige doeleinden, zoals politieke propaganda, spionage en informatieoorlogvoering.

Om ze te maken, heb je iets nodig dat een diep neuraal netwerk wordt genoemd, een computersysteem dat de manier nabootst waarop de hersenen leren. Dit wordt 'getraind' door het bloot te stellen aan steeds grotere datasets van echte gezichten.

In feite zijn er twee diepe neurale netwerken die tegen elkaar strijden om de meest realistische beelden te produceren. Als gevolg hiervan worden de eindproducten GAN-afbeeldingen genoemd, waarbij GAN staat voor Generative Adversarial Networks. Het proces genereert nieuwe beelden die statistisch niet te onderscheiden zijn van de trainingsbeelden.

In onze studie gepubliceerd in iScience, toonden we aan dat het niet onderscheiden van deze kunstmatige gezichten gevolgen heeft voor ons online gedrag. Ons onderzoek suggereert dat de nepafbeeldingen ons vertrouwen in anderen kunnen aantasten en de manier waarop we online communiceren ingrijpend kunnen veranderen.

Mijn collega's en ik ontdekten dat mensen GAN-gezichten als nog realistischer beschouwden dan echte foto's van echte mensengezichten. Hoewel het nog niet duidelijk is waarom dit zo is, doet deze bevinding dat wel belicht de recente ontwikkelingen in de technologie gebruikt om kunstmatige afbeeldingen te genereren.

En we vonden ook een interessante link met aantrekkelijkheid: gezichten die als minder aantrekkelijk werden beoordeeld, werden ook als echter beoordeeld. Minder aantrekkelijke gezichten kunnen als typischer worden beschouwd het typische gezicht kan als referentie worden gebruikt waartegen alle gezichten worden beoordeeld. Daarom zouden deze GAN-gezichten er echter uitzien omdat ze meer lijken op mentale sjablonen die mensen uit het dagelijks leven hebben opgebouwd.

Maar het als authentiek beschouwen van deze kunstmatige gezichten kan ook gevolgen hebben voor het algemene niveau van vertrouwen dat we uitstrekken tot een kring van onbekende mensen - een concept dat bekend staat als "sociaal vertrouwen".

We lezen vaak te veel in de gezichten die we zien, en de eerste indrukken die we vormen, sturen onze sociale interacties. In een tweede experiment dat deel uitmaakte van onze laatste studie, zagen we dat mensen meer geneigd waren informatie te vertrouwen die werd overgebracht door gezichten waarvan ze eerder dachten dat ze echt waren, zelfs als ze kunstmatig waren gegenereerd.

Het is niet verwonderlijk dat mensen meer vertrouwen stellen in gezichten waarvan ze denken dat ze echt zijn. Maar we ontdekten dat het vertrouwen werd aangetast zodra mensen werden geïnformeerd over de mogelijke aanwezigheid van kunstmatige gezichten in online interacties. Vervolgens toonden ze over het algemeen een lager niveau van vertrouwen, ongeacht of de gezichten echt waren of niet.

Dit resultaat zou in sommige opzichten als nuttig kunnen worden beschouwd, omdat het mensen meer wantrouwend maakte in een omgeving waar mogelijk nepgebruikers actief zijn. Vanuit een ander perspectief kan het echter geleidelijk de aard van onze manier van communiceren aantasten.

Over het algemeen hebben we de neiging om door te opereren een standaardaanname dat andere mensen in wezen waarheidsgetrouw en betrouwbaar zijn. De groei van nepprofielen en andere kunstmatige online-inhoud roept de vraag op in hoeverre hun aanwezigheid en onze kennis over hen deze toestand van "waarheidsgebrek" kan veranderen en uiteindelijk het sociale vertrouwen kan aantasten.

Onze standaardwaarden wijzigen

De overgang naar een wereld waarin wat echt is niet te onderscheiden is van wat niet, kan ook het culturele landschap doen verschuiven van voornamelijk waarheidsgetrouwheid naar voornamelijk kunstmatig en bedrieglijk.

Als we regelmatig twijfelen aan de waarheidsgetrouwheid van wat we online ervaren, kan het nodig zijn dat we onze mentale inspanning verleggen van het verwerken van de berichten zelf naar het verwerken van de identiteit van de boodschapper. Met andere woorden, het wijdverbreide gebruik van zeer realistische, maar kunstmatige, online-inhoud zou ons kunnen verplichten om anders te denken - op manieren die we niet hadden verwacht.

In de psychologie gebruiken we een term die 'realiteitsmonitoring' wordt genoemd voor hoe we correct identificeren of iets uit de buitenwereld of uit onze hersenen komt. De vooruitgang van technologieën die valse, maar zeer realistische gezichten, afbeeldingen en videogesprekken kunnen produceren, betekent dat het monitoren van de werkelijkheid gebaseerd moet zijn op andere informatie dan onze eigen oordelen. Het roept ook op tot een bredere discussie over de vraag of de mensheid het zich nog steeds kan veroorloven om standaard de waarheid te volgen.

Het is cruciaal dat mensen kritischer zijn bij het beoordelen van digitale gezichten. Dit kan het gebruik van reverse image searches omvatten om te controleren of foto's echt zijn, op uw hoede zijn voor profielen op sociale media met weinig persoonlijke informatie of een groot aantal volgers, en zich bewust zijn van de mogelijkheid dat deepfake-technologie voor snode doeleinden wordt gebruikt.

De volgende grens voor dit gebied zouden verbeterde algoritmen moeten zijn voor het detecteren van valse digitale gezichten. Deze kunnen vervolgens worden ingebed in sociale-mediaplatforms om ons te helpen de echte van de nep te onderscheiden als het gaat om de gezichten van nieuwe connecties.

Over de auteur

Manos Tsakiris, hoogleraar psychologie, directeur van het Centrum voor Politiek van Gevoelens, Royal Holloway University of London

Dit artikel is opnieuw gepubliceerd vanaf The Conversation onder een Creative Commons-licentie. Lees de originele artikel.