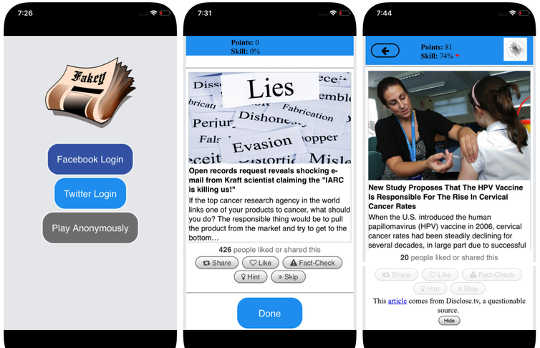

Schermafbeeldingen van het Fakey-spel. Mihai Avram en Filippo Menczer

Schermafbeeldingen van het Fakey-spel. Mihai Avram en Filippo Menczer

Sociale media behoren tot de primaire nieuwsbronnen in de VS. en over de hele wereld. Toch worden gebruikers blootgesteld aan inhoud van twijfelachtige nauwkeurigheid, waaronder complottheorieën, clickbait, hyperpartisan inhoud, pseudo-wetenschap en zelfs gefabriceerde nepnieuwsrapporten.

Het is niet verwonderlijk dat er zoveel desinformatie is gepubliceerd: spam en online fraude zijn lucratief voor criminelen, en de overheid en politieke propaganda leveren op zowel partijdige als financiële voordelen. Maar het feit dat laag-geloofwaardige inhoud verspreidt zich zo snel en gemakkelijk suggereert dat mensen en de algoritmen achter sociale-mediaplatformen gevoelig zijn voor manipulatie.

Ons onderzoek heeft drie soorten vooringenomenheid geïdentificeerd die het ecosysteem van de sociale media kwetsbaar maken voor zowel opzettelijke als toevallige verkeerde informatie. Dat is de reden waarom onze Observatorium op sociale media op Indiana University is aan het bouwen tools mensen helpen zich bewust te worden van deze vooroordelen en zichzelf beschermen tegen invloeden van buitenaf die zijn ontworpen om ze te misbruiken.

Uitleg over de tools ontwikkeld door het Observatorium op sociale media:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

Bias in de hersenen

Cognitieve vooroordelen vinden hun oorsprong in de manier waarop het brein de informatie verwerkt die elke persoon elke dag tegenkomt. De hersenen kunnen slechts een eindige hoeveelheid informatie verwerken en te veel binnenkomende stimuli veroorzaken informatie-overload. Dat heeft op zichzelf ernstige gevolgen voor de kwaliteit van informatie op sociale media. We hebben geconstateerd dat een steile concurrentie voor de beperkte aandacht van gebruikers dat betekent sommige ideeën gaan viral ondanks hun lage kwaliteit - zelfs wanneer mensen inhoud van hoge kwaliteit delen.

Om te voorkomen dat je overweldigd raakt, gebruiken de hersenen een aantal tricks. Deze methoden zijn meestal effectief, maar kunnen ook vooroordelen worden wanneer toegepast in de verkeerde contexten.

Een cognitieve snelkoppeling vindt plaats wanneer een persoon beslist om een verhaal te delen dat op zijn social media-feed verschijnt. Mensen zijn erg beïnvloed door de emotionele connotaties van een kop, ook al is dat geen goede indicator voor de nauwkeurigheid van een artikel. Veel belangrijker is wie heeft het stuk geschreven.

Om deze vooringenomenheid tegen te gaan en mensen te helpen meer aandacht te besteden aan de bron van een claim voordat deze werd gedeeld, hebben we ons ontwikkeld Fakey, een mobiel nieuwsleergame-spel (gratis op Android en iOS) het simuleren van een typische nieuwsfeed voor social media, met een mix van nieuwsartikelen uit reguliere en laag-geloofwaardige bronnen. Spelers krijgen meer punten voor het delen van nieuws uit betrouwbare bronnen en het markeren van verdachte inhoud voor fact-controle. Daarbij leren ze signalen van geloofwaardigheid van bronnen herkennen, zoals claims van hyperpartijen en emotioneel geladen koppen.

Bias in de samenleving

Een andere bron van vooringenomenheid komt van de samenleving. Wanneer mensen rechtstreeks contact maken met hun leeftijdsgenoten, beïnvloeden de sociale vooroordelen die hun selectie van vrienden leiden, de informatie die ze zien.

In feite hebben we in ons onderzoek ontdekt dat het mogelijk is om dit te doen bepalen de politieke voorkeuren van een Twitter-gebruiker door gewoon naar de partijdige voorkeuren van hun vrienden te kijken. Onze analyse van de structuur hiervan partijdige communicatienetwerken gevonden sociale netwerken zijn bijzonder efficiënt in het verspreiden van informatie - juist of niet - wanneer ze zijn nauw met elkaar verbonden en losgekoppeld van andere delen van de samenleving.

De neiging om informatie gunstiger te evalueren als het afkomstig is van hun eigen sociale kringen creëert "echokamers"Die rijp zijn voor manipulatie, bewust of onopzettelijk. Dit helpt verklaren waarom zoveel online gesprekken overgaan "Wij versus zij" confrontaties.

Om te bestuderen hoe de structuur van online sociale netwerken gebruikers kwetsbaar maakt voor desinformatie, hebben we gebouwd Hoaxy, een systeem dat de verspreiding van inhoud van bronnen met lage geloofwaardigheid traceert en visualiseert, en hoe het concurreert met inhoud voor feitcontrole. Onze analyse van de gegevens verzameld door Hoaxy tijdens de 2016 Amerikaanse presidentsverkiezingen laat zien dat Twitter-accounts met gedeelde desinformatie waren bijna volledig afgesneden van de correcties die zijn aangebracht door de fact-checkers.

Toen we de misleidende verslagen verspreidden, ontdekten we dat een zeer dichte kerngroep van accounts bijna uitsluitend elkaar retweet, waaronder verschillende bots. De enige keren dat fact-checking organisaties ooit werden geciteerd of genoemd door de gebruikers in de verkeerd geïnformeerde groep waren bij het in twijfel trekken van hun legitimiteit of het beweren van het tegenovergestelde van wat ze schreven.

Bias in de machine

De derde groep van vooroordelen komt rechtstreeks voort uit de algoritmen die worden gebruikt om te bepalen wat mensen online zien. Zowel sociale mediaplatforms als zoekmachines gebruiken deze. Deze personalisatietechnologieën zijn ontworpen om alleen de meest boeiende en relevante inhoud voor elke individuele gebruiker te selecteren. Maar door dit te doen, kan het uiteindelijk de cognitieve en sociale vooroordelen van gebruikers versterken, waardoor ze nog kwetsbaarder worden voor manipulatie.

Bijvoorbeeld de gedetailleerde advertentietools ingebouwd in veel social-mediaplatforms laat desinformatiecampagnevoerders misbruik maken voorkeur voor bevestiging by berichten aanpassen voor mensen die al geneigd zijn om ze te geloven.

Als een gebruiker vaak op Facebook-links van een bepaalde nieuwsbron klikt, zal Facebook dat ook doen hebben de neiging om die persoon meer inhoud van die site te laten zien. Deze zogenaamde "filterbubbel"Effect kan mensen isoleren vanuit verschillende perspectieven, wat de bevestiging van de bevestiging versterkt.

Ons eigen onderzoek toont aan dat sociale-mediaplatformen gebruikers blootstellen aan een minder diverse reeks bronnen dan niet-sociale mediasites zoals Wikipedia. Omdat dit op het niveau van een volledig platform is, niet van een enkele gebruiker, noemen we dit het homogeniteitsbias.

Een ander belangrijk ingrediënt van sociale media is informatie die trending is op het platform, op basis van wat de meeste klikken genereert. We noemen dit populariteitsbiasomdat we hebben ontdekt dat een algoritme dat is ontworpen om populaire inhoud te promoten, de algehele kwaliteit van informatie op het platform negatief kan beïnvloeden. Dit voedt zich ook in bestaande cognitieve vooringenomenheid en versterkt wat populair lijkt, ongeacht de kwaliteit ervan.

Al deze algoritmische vooroordelen kunnen worden gemanipuleerd door sociale bots, computerprogramma's die communiceren met mensen via sociale-mediarekeningen. De meeste sociale bots, zoals Twitter's Big Ben, zijn onschadelijk. Sommigen verbergen echter hun ware aard en worden gebruikt voor kwaadwillende bedoelingen, zoals het stimuleren van desinformatie of vals het uiterlijk van een basisbeweging creëren, ook wel 'astroturfing' genoemd. We vonden dat bewijs van dit type manipulatie in de aanloop naar de 2010 US midterm-verkiezing.

Om deze manipulatiestrategieën te bestuderen, hebben we een hulpmiddel ontwikkeld om sociale bots te detecteren Botometer. Botometer gebruikt machinaal leren om botaccounts te detecteren, door duizenden verschillende functies van Twitter-accounts te inspecteren, zoals de tijden van de berichten, hoe vaak het tweets, en de accounts die het volgt en retweets. Het is niet perfect, maar het heeft onthuld dat zoveel als 15 procent van Twitter-accounts vertoont tekenen van bots.

Met behulp van Botometer in combinatie met Hoaxy analyseerden we de kern van het desinformatie-netwerk tijdens de 2016 presidentiële campagne in de VS. We hebben veel bots gevonden die zowel de cognitieve, confirmatie- als populariteitsvooroordelen van hun slachtoffers en de algoritmische vooroordelen van Twitter benutten.

Deze bots kunnen filterbellen rond kwetsbare gebruikers maken, ze valse claims en verkeerde informatie geven. Ten eerste kunnen ze de aandacht trekken van menselijke gebruikers die een bepaalde kandidaat ondersteunen door de hashtags van die kandidaat te tweeten of door de persoon te vermelden en te retweeten. Dan kunnen de bots valse claims versterken door tegenstanders uit te smeren door artikelen uit bronnen met een lage geloofwaardigheid te retweeten die overeenkomen met bepaalde sleutelwoorden. Deze activiteit zorgt er ook voor dat het algoritme voor andere gebruikers valse verhalen markeert die op grote schaal worden gedeeld.

Complexe kwetsbaarheden begrijpen

Zelfs als ons onderzoek, en dat van anderen, laat zien hoe individuen, instellingen en zelfs hele samenlevingen kunnen worden gemanipuleerd op sociale media, dat zijn er wel veel vragen links om te beantwoorden. Het is vooral belangrijk om te ontdekken hoe deze verschillende vooroordelen met elkaar interageren, waardoor mogelijk complexere kwetsbaarheden worden gecreëerd.

Tools zoals de onze bieden internetgebruikers meer informatie over desinformatie, en daarom enige mate van bescherming tegen de nadelen. De oplossingen zullen waarschijnlijk niet alleen technologisch, hoewel er waarschijnlijk een aantal technische aspecten aan hen zullen zijn. Maar ze moeten rekening houden met de cognitieve en sociale aspecten van het probleem.

Over de Auteurs

Giovanni Luca Ciampaglia, assistent-onderzoekswetenschapper, Indiana University Network Science Institute, Indiana University en Filippo Menczer, hoogleraar computerwetenschappen en informatica; Directeur van het Centrum voor Complexe Netwerken en Systeemonderzoek, Indiana University

Dit artikel is oorspronkelijk gepubliceerd op The Conversation. Lees de originele artikel.

Verwante Boeken

at

Bedankt voor het bezoeken InnerSelf.com, waar er zijn 20,000+ levensveranderende artikelen waarin ‘nieuwe attitudes en nieuwe mogelijkheden’ worden gepromoot. Alle artikelen zijn vertaald naar 30+ talen. Inschrijven aan InnerSelf Magazine, dat wekelijks verschijnt, en Marie T Russell's Daily Inspiration. InnerSelf Magazine verschijnt sinds 1985.

Bedankt voor het bezoeken InnerSelf.com, waar er zijn 20,000+ levensveranderende artikelen waarin ‘nieuwe attitudes en nieuwe mogelijkheden’ worden gepromoot. Alle artikelen zijn vertaald naar 30+ talen. Inschrijven aan InnerSelf Magazine, dat wekelijks verschijnt, en Marie T Russell's Daily Inspiration. InnerSelf Magazine verschijnt sinds 1985.